El mundo tiene muchos lugares apasionantes. ¿En qué lugar de la Tierra está Alemania?

Alemania está en Europa. Está al otro lado del océano Atlántico, frente a Estados Unidos. Hay muchas cosas que ver en Alemania.

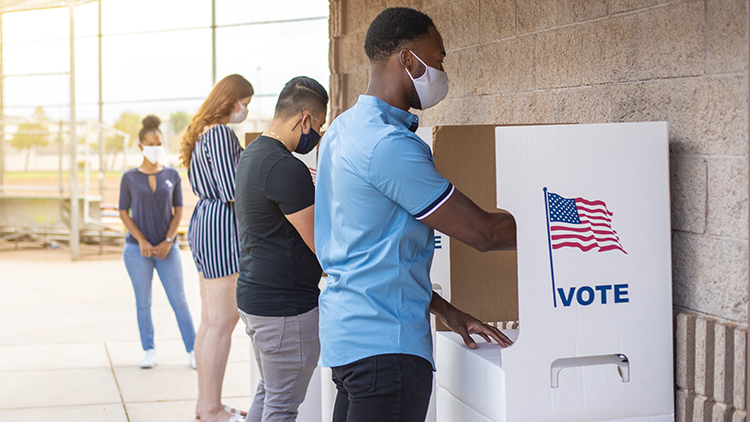

En Estados Unidos, el día de las elecciones es el … read more

El Día de los Patriotas es el 17 de abril. … read more

Esta es la Cámara de Representantes. Los representantes de todo … read more

© 2026 McGraw-Hill Education. All Rights Reserved.